Mehr Rechenleistung für HILBERT und die Forschung der Zukunft

Heinrich-Heine-Universität Düsseldorf erweitert HPC-Cluster mit SVA und Supermicro

Heinrich-Heine-Universität Düsseldorf

Die Heinrich-Heine-Universität Düsseldorf ist eine der jüngeren Hochschulen des Landes NRW – gegründet 1965. Seit 1988 trägt die Universität den Namen des großen Sohnes der Stadt. Heute finden auf dem modernen Campus rund 35.000 Studierende beste Bedingungen für das akademische Leben.

Das Zentrum für Informations- und Medientechnologie ZIM der Heinrich-Heine-Universität ist das Dienstleistungs- und Kompetenzzentrum für alle Aspekte der digitalen Informationsversorgung und -verarbeitung, der digitalen Kommunikation und des Einsatzes digitaler Medien. Es bietet Technologien, Beratung und Dienstleistungen für Forschung, Lehre, Studium und Verwaltung an und betreibt dafür leistungsfähige Infrastrukturen wie das kabelgebundene Kommunikationsnetz, das flächendeckende WLAN, eine Server-Infrastruktur.

Herausforderung High Performance Computing (HPC)

HPC-Cluster sind für die moderne Forschung unerlässlich und ein Aushängeschild für viele Universitäten: Mehr Rechenpower, mehr Möglichkeiten und besseres wissenschaftliches Arbeiten, mehr Renommee für die Uni. Sie müssen jedoch immer wieder erneuert bzw. erweitert werden, so auch der vorhandene HPC-Cluster HILBERT in Düsseldorf. Wichtig waren hier für die Erweiterung der Einsatz der neuesten Intel CPU-Generation ICELAKE, ein leistungsfähiges Netzwerk sowie eine einfache Integrierbarkeit in HILBERT. Diese betraf dabei sowohl die gewählten Systeme, die Netzwerk-Infrastruktur als auch die damit einhergehende Konsistenz der Managementlösung. Grundsätzlich sollten mehr Performance per Watt bei gleichem Energie-Budget erreicht werden.

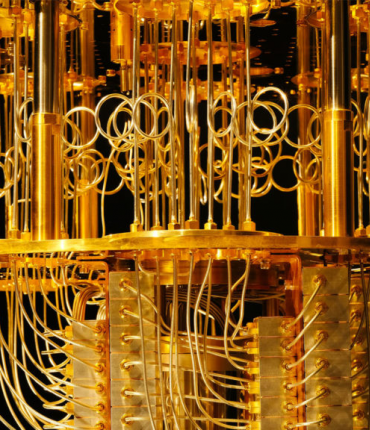

Lösung mit Supermicro

Der bestehende HPC-Cluster HILBERT wurde mit leistungsfähiger und moderner Hardware erweitert. Um das Management der neuen Infrastruktur möglichst konsistent mit der vorhandenen zu halten, wurde wie bei dieser auf die neueste Generation von SuperBlade Systemen von Supermicro zurückgegriffen. Die Leistungsfähigkeit der modernen CPUs im Clusterverbund wird mit einer 200 Gbps Infiniband Fabric sichergestellt.

Die Erweiterungs-Cluster bestehen aus fünf SuperBlade 8U-Gehäusen mit jeweils 20 Dual Socket CPU Nodes. Jeder dieser CPU Nodes ist mit zwei Intel ICELAKE 6356 CPUs ausgestattet und diese verfügen über jeweils 16 Cores, die mit 3.1 GHz Grundfrequenz und 3.6 GHz Turbofrequenz laufen. Mit jeweils zwei AVX512 Einheiten pro Core und hoher Grundfrequenz eignen sich diese CPUs besonders gut für Simulationen und Modellierungen. Durch den um Vector Neural Network Instructions (VNNI) erweiterten Befehlssatz wird so auch der Einsatz bei Maschine Learning oder Artificial Intelligence möglich. Die Anbindung an die 256 GB Memory erfolgt über 16 x 16 GB DDR4-3200 DIMM-Module, die jeweils einen Memory-Kanal der CPU belegen. Die theoretische maximale Memory-Bandbreite pro CPU beträgt damit ~205 GB/s Die CPU verbraucht in der Spitze 205 W und optimierte Latenz beim Power-Management ermöglicht eine Verbesserung der Performance pro Watt. Zur Performance-Effizienz tragen zusätzlich die acht redundanten Hot-Swap Titanium Level PSU bei, mit je 2200 W und einer Energieeffizienz von bis zu 96% bei 50% Belastung.

Mit der ConnectX-6 VPI AOC-Karte von Nvidia/Mellanox erfolgt die einfache Anbindung der Compute Nodes mit 200 Gbps an das interne High Speed 200 Gbps HDR Infiniband- Netzwerk. Die Switche erlauben zudem eine gezielte Partitionierung aller neuen performanten ICELAKE CPU Nodes, um ein Maximum an Performance zu erreichen. An die externen HDR-Switche ist die Lösung über den integrierten Infiniband HDR-Switch in einem Leaf-Spine-Konzept angebunden. Insgesamt stehen damit zusätzliche 3.200 Cores mit einer Taktfrequenz von mindestens 3.1 GHz und 25,6 TB Hauptspeicher für rechenintensive Applikationen zur Verfügung.

Die ausgewählte Blade-Lösung bietet hier gleich mehrere Vorteile: Mit dem zentralen Blade-Management lassen sich die einzelnen Compute Nodes auch über mehrere Blade- Chassis einfach verwalten, was Zeit beim täglichen Management des Clusters einspart. Zudem bieten die Blade-Chassis mit ihrem integrierten Infiniband-Switch eine deutlich vereinfachte Verdrahtung über die integrierte Backplane und sparen damit teure 200 Gbps Kabel. Schlussendlich erlauben zentrale Stromversorgung und Kühlungskonzept eine energieeffiziente Lösung, die auch aktuell einen kostengünstigen und effizienten Betrieb ermöglicht.

Optimales Ergebnis

Die Erwartungen und Anforderungen des ZIM wurden voll erfüllt – und dies trotz aktuell schwieriger Lieferbedingungen und Problemen in der Lieferkette. Durch die enge Zusammenarbeit und Abstimmung zwischen ZIM, SVA und Supermicro zu Zielen und Abhängigkeiten konnte die Integration der neuen Lösung in die vorhandene Infrastruktur schnell, unkompliziert und erfolgreich durchgeführt werden. Dabei wird durch den Einsatz der modernen, performanten und energieeffizienten CPUs und der Infiniband High Speed Fabric nun eine schnellere Time-to-Solution erreicht. Es können mehr und komplexere Jobs pro Zeiteinheit auf dem HPC-Cluster gerechnet und täglich kleinere Einsparungen im Management erreicht werden. Den ZIM-Mitarbeitern somit eine moderne, leistungsfähige HPC-Infrastruktur zur Verfügung stellen zu können, bedeutet auch, das Renommee der Universität zu steigern und den wissenschaftlichen Mitarbeitern den nötigen Schub für ihre Forschungen zu geben.